Estos algoritmos ya deciden si te dan la condicional o si tu denuncia es falsa: Eticas lanza un buscador para conocer las IA que ya inciden en tu vida diaria

- Eticas, la fundación que hace auditorías a los sistemas de IA para evitar discriminaciones, lanza el Observatorio de Algoritmos con Impacto Social, el OASI.

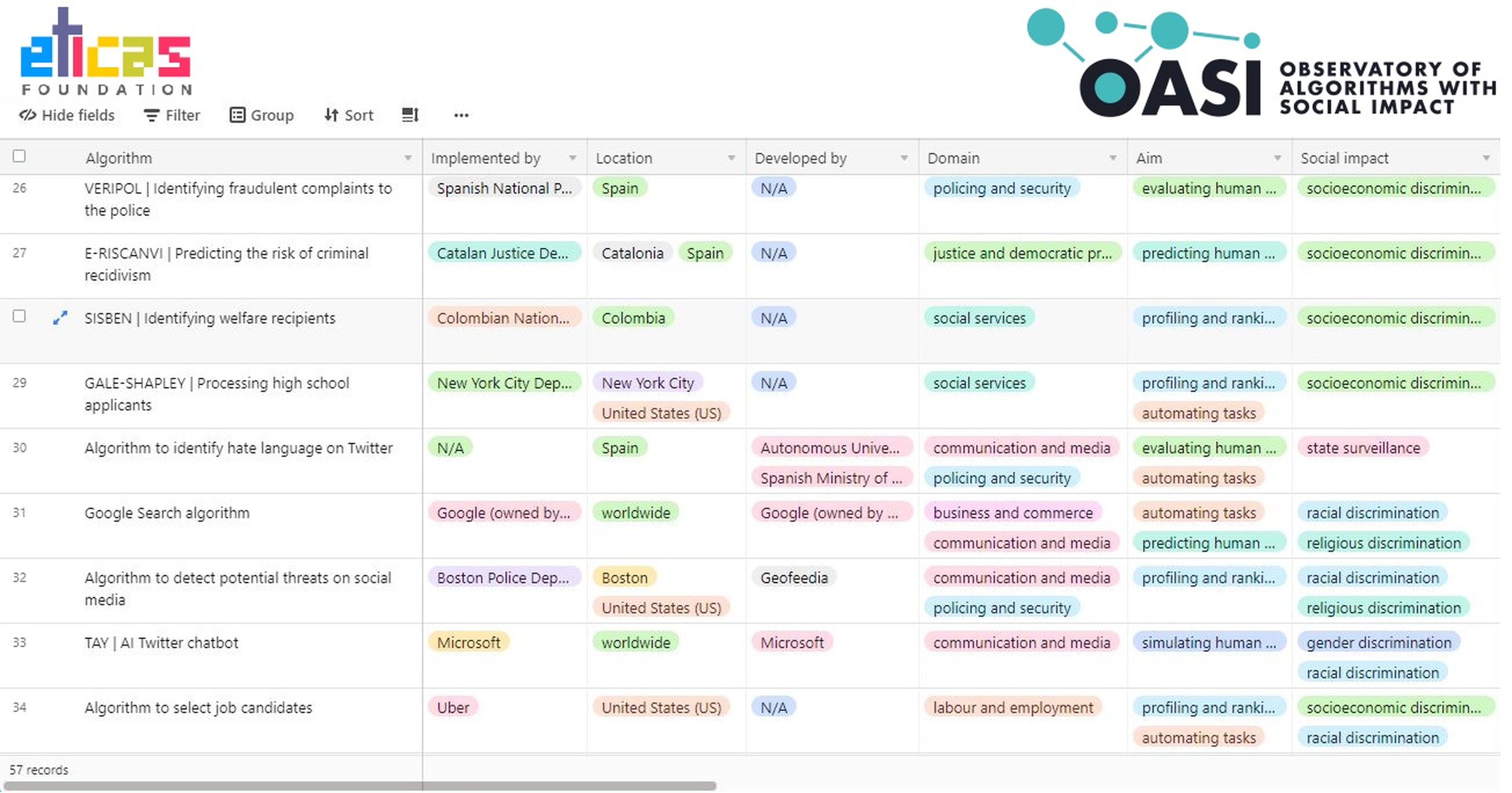

- Se trata de una tabla de acceso público en el que se pueden comprobar qué algoritmos (en España y en el mundo) ya inciden sobre nuestra vida y si están auditados o no.

- El informe, que está en constante crecimiento, también detalla cuáles son las metas y posibles riesgos de los sistemas de IA que lista.

- Descubre más historias en Business Insider España.

Los modelos de inteligencia artificial pueden conllevar una serie de riesgos sociales desde el momento en el que estos son opacos, no se explican y sus recomendaciones pueden ser determinantes para las vidas de las personas.

Esta misma semana el Parlamento Europeo ha votado a favor de prohibir estos sistemas para fines policiales como el de la vigilancia masiva o el reconocimiento de personas a través de datos biométricos (su rostro, sus huellas dactilares). Sin embargo, la resolución que prosperó en la Eurocámara no es vinculante.

Gemma Galdon es, en España, una de las mayores expertas en ética algorítmica. Es la fundadora y directora general de Eticas, el nombre que recibe tanto una compañía especializada en auditoría de IA como una fundación que realiza estas auditorías sobre estos modelos, cuando ya están implementados en ámbitos críticos para la vida y privacidad de los ciudadanos.

Ahora Eticas ha lanzado un Observatorio de Algoritmos con Impacto Social, OASI en sus siglas en inglés, que en una tabla de acceso público lista y detalla una serie de sistemas ya desplegados por países, por fines y por principales riesgos.

En la lista ya aparecen sistemas de IA empleados por el Cuerpo Nacional de Justicia, por la Conselleria de Justicia de la Generalitat de Cataluña, por el Servicio de Empleo Público Estatal (SEPE) o por la Oficina Nacional de Lucha Contra los Delitos de Odio dependiente del Ministerio del Interior.

Para entender lo sensibilísimos que pueden ser estos algoritmos, basta con detallar sus usos y fines: el primero determina si una denuncia que has interpuesto es falsa o no, y el segundo puede intervenir sobre la pertinencia o no de que disfrutes de una pena condicional en función de las probabilidades que hay de que seas un criminal reincidente.

El algoritmo del SEPE automatiza la decisión de que un desempleado cuente con oportunidades, cursos y otros beneficios de su condición, mientras que el cuarto vigila el lenguaje de odio que hay en plataformas sociales como Twitter.

Los algoritmos que ya están en nuestra vida

Eticas

RisCanvi es el sistema de IA que aplican las prisiones catalanes sobre su población penitenciaria. El primer informe del OASI, que puedes consultar aquí, destaca que su objetivo es tan ambicioso como "predecir el comportamiento humano" y que el principal riesgo que genera su naturaleza es "una discriminación socioeconómica".

Sin embargo, Eticas pormenoriza en RisCanvi destacando que el modelo no decide solo: su recomendación se toma en cuenta por un equipo multidisciplinar de expertos, lo que no es en ningún caso un defecto. "Que el sistema no sea exhaustivo y dependa del ser humano está en consonancia con la política actual de protección de datos", recuerda la fundación.

Más problemático parece VeriPol, creado por un equipo de investigadores para ayudar a la policía "a identificar denuncias fraudulentas". Usa el procesamiento del lenguaje natural y el aprendizaje automático para analizar una llamada telefónica que esté denunciando un ilícito. Predice si es falsa o no en función de qué tipo de agresión ha sido, qué detalles da el denunciante y su morfosintaxis.

Eticas detecta que este sistema puede ser discriminatorio porque al tener en cuenta esta última variable, el algoritmo podría dar falsos positivos en caso de que quien llamase fuese "una persona con menos formación o no nativa". "Deberían investigarse cuestiones como ésta para proteger a las poblaciones vulnerables contra la discriminación automática".

Un debate urgente

El de la ética algorítmica es un debate urgente, ya que muchos de estos automatismos están desplegados y en funcionamiento. Eticas cita a varios autores al señalar que las ayudas y prestaciones al desempleo se han reducido en un 50% desde que se implementó la IA en el SEPE. Probablemente la IA no sea el único factor, admite la fundación.

Pero "los expertos sostienen que la conciliación de datos deficiente, o el mal funcionamiento del sistema derivado de datos incorrectos y errores de entrada, es un problema inevitable y habitual en los sistemas algorítmicos y es el probable culpable en el SEPE", advierte.

El nuevo OASI no solo incluye algoritmos de España. Hay casos en Argentina, donde unos algoritmos cuentan con la presunta capacidad de predecir si una adolescente tiene más probabilidades de quedarse embarazada, u otro que supuestamente predice la propensión de un adolescente a consumir alcohol o drogas.

También se inscriben algoritmos que deciden sobre nosotros día a día, como los sistemas que generan contenido recomendado de forma automática en plataformas tan populares como YouTube, Google Imágenes o Facebook. Se incluye además iBorderCtrl, una suerte de "máquina de la verdad" que se testeó en fronteras europeas.

Más de 50 algoritmos en su primera fase

El OASI que Eticas Foundation lanza este viernes lista hasta 57 algoritmos, aunque en una nota de prensa la firma confía en sumar más de 100 en cuestión de meses. Los principales riesgos que la fundación ha detectado en los modelos analizados son los perjuicios ocasionados por edad, género, raza o discapacidad.

Es difícil encontrar responsables en un algoritmo con sesgos. Gemma Galdon ya ha explicado en varias ocasiones que la mayoría de desarrolladores de estos sistemas no buscan discriminar intencionadamente, pero al producir sobre una base de conocimientos y datos única pueden perpetuar sesgos inconscientes y no deliberados, si estos modelos no se someten a auditoría.

Ocurre especialmente con los algoritmos de aprendizaje automático: estos modelos se entrenan con grandes cantidades de datos históricos, pasados. Dado que muchos de esos datos no serán representativos de la realidad socioeconómica o cultural, aunque la IA arroje resultados 'correctos' desde el punto de vista de su entrenamiento, estos podrían ser discriminatorios.

OASI es una iniciativa más de Eticas, que ha trabajado con compañías como Alpha Telefónica, Naciones Unidas, Koa Health o el Banco Interamericano de Desarrollo, y hace unos meses liberó una guía de auditorías algorítmicas para animar a más empresas a auditar sus propios sistemas. Una de las auditorías que Eticas está realizando es sobre VioGén.

VioGén es el agoritmo usado por el Ministerio de Interior para asignar riesgo a las mujeres que buscan protección tras sufrir casos de violencia machista. Eticas realiza estas auditorías haciendo ingeniería inversa y usando datos administrativos, entrevistas y escrutando tanto informes como guiones del diseño del modelo para después "recopilar resultados a escala".

"A pesar de que existen métodos de control y auditoría de algoritmos para garantizar que la tecnología respete la regulación vigente y los derechos fundamentales, la Administración y muchas compañías siguen haciendo oídos sordos a las peticiones de transparencia de ciudadanos e instituciones", lamenta Gemma Galdon, la fundadora de Eticas.

Otros artículos interesantes:

Descubre más sobre Alberto R. Aguiar, autor/a de este artículo.

Conoce cómo trabajamos en Business Insider.